Jedes Bild erzählt eine Geschichte. Welche, dass sollen schon bald intelligente Analysetools in kurze Worte, sprich automatisch generierte Bildunterschriften, fassen können. Dabei sind die beiden Forschungsteams offensichtlich schon sehr weit, wie kürzlich veröffentliche Beispiele zeigen. Während Menschen in kurzen Sätzen Inhalte von Bildern und Filmclips sehr genau und kurz beschreiben können (zum Beispiel: Landschaft mit Pferd und Reiter), fällt dies Computern bisher schwer. Dabei wäre es angesichts der ständig wachsenden Bilderflut zudem ausgesprochen nützlich, wenn zusätzlich zu den inzwischen in den meisten Bildern vorhandenen Metadaten über Ort und Zeit auch in ganzen Sätzen formulierte Beschreibungen der Inhalte zur Verfügung stünden. Nicht nur das es die Verwaltung von Bildern enorm vereinfachen würde, es könnte für Menschen mit langsameren Rechnern und Internetverbindungen die Bildsuche enorm beschleunigen. Die meisten Bildarchive basieren heute auf sprachliche Beschreibungen der Bildinhalte. Eine automatische Verschlagwortung der Milliarden nicht mit Kommentaren versehenen Videos und Fotos würde die Bildersuche sehr viel effektiver und schneller machen.

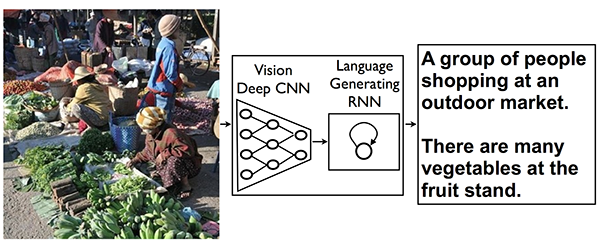

Funktionsschema nach dem Google Wissenschaftler automatische Bildunterschriften erstellen.

Auf Googles Research Blog, wo das Unternehmen über seine Forschungsziele und -ergebnisse berichtet, haben die vier Wissenschaftler Oriol Vinyals, Alexander Toshev, Samy Bengio und Dumitru Erhan kürzlich berichtet, wie weit ihre Bemühungen gediehen sind, Rechnern beizubringen, Bildunterschriften in ganzen Sätzen zu formulieren. Bisher war es Forschern bereits weitgehen gelungen Motive zu lokalisieren, zu Klassifizieren und mit Wörtern zu beschriften. Nun sind sie dabei die ganze, abgebildete Geschichte mit einem knappen Satz in natürlich wirkender Sprache zu formulieren. Dazu haben sie modernste Methoden der Bildanalyse und der Spracherzeugung miteinander verknüpft. Einige der angewandten Methoden verwenden auch Erkenntnisse der automatischen Übersetzungstools, die beispielsweise – sehr vereinfacht ausgedrückt – mit einer Art Vektortechnik französische Sätze ins Deutsche übertragen.

Die Google Forscher haben dies mit zahlreichen öffentlich zur Verfügung stehenden Datensets, darunter auch flickr ausprobiert und sind dabei zu überraschend präzisen Ergebnissen bei den automatisch generierten Bildunterschriften gelangt.

Eine Hauptproblem das die Forscher im Google Research Blog Spot beschreiben, besteht darin, herauszufinden, welche Objekte im Bild so wichtig sind, dass sie in die Bildunterschrift aufgenommen werden sollen. Die Ergebnisse ihrer Forschungen haben sie unter arXiv.org, einer Open Ressource Plattform der Cornell University (Ithaka, NY) veröffentlicht.

Das gleiche Ziel wie die Forscher von Google verfolgen laut des Artikels in der New York Times (zum Artikel) die beiden Wissenschaftler Dr. Fei-Fei Li und Andrej Karpathy an der Standford University. Ihren Bericht haben sie auf der Plattform der Stanford University unter diesem Link veröffentlicht.